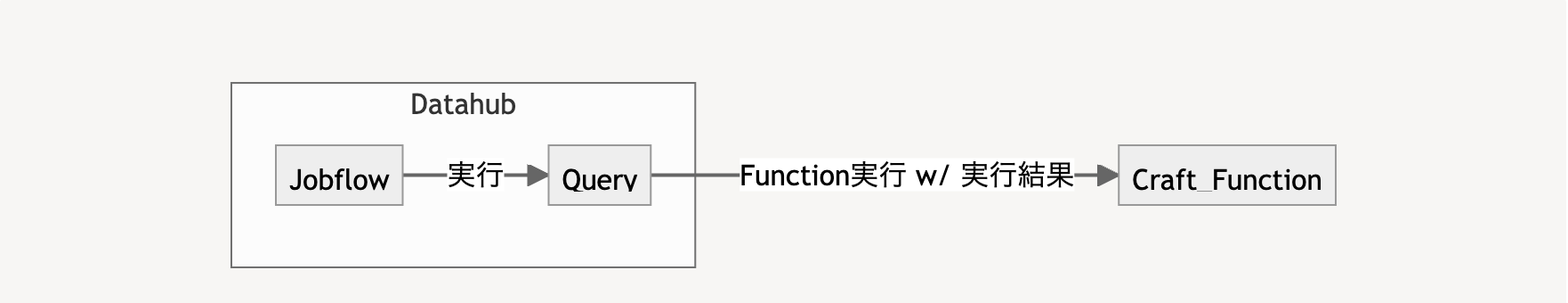

ジョブフローから実行する(Datahub Jobflow Connector)

Datahub Jobflow Connector では、Datahub Jobflow の実行結果を data として Function に送信します。

設定手順

以下の手順で Datahub Jobflow Connector を設定します。

初期設定の確認

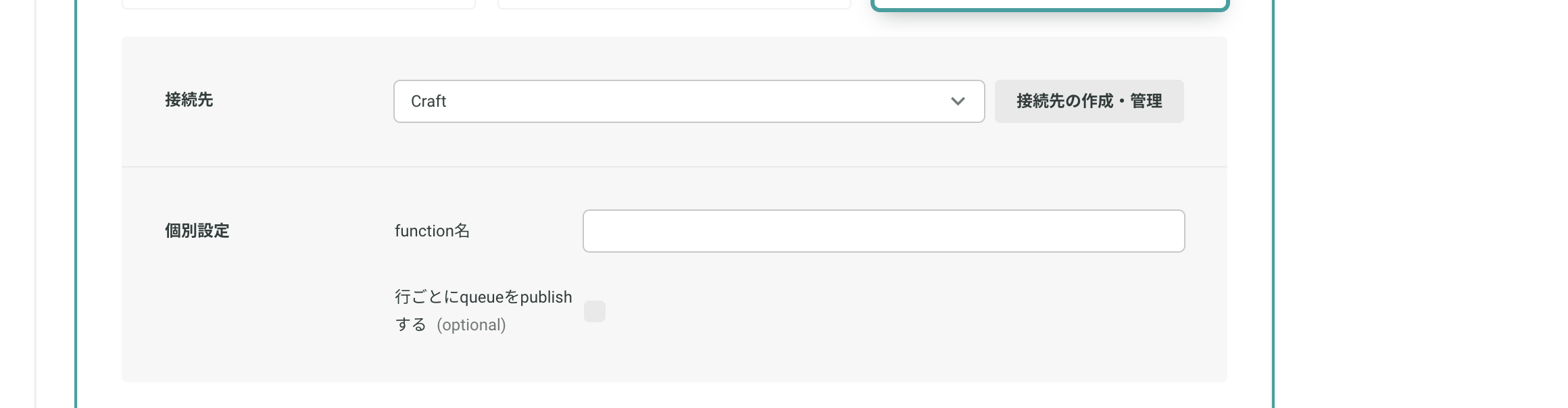

[Datahub] > [ジョブフロー] > [作成] で表示されるジョブフロー作成画面にて、[ジョブの追加] > [データテーブルへインポート/クエリ実行結果のエクスポート] > [接続先の作成・管理] を選択します。接続先に「Craft」が追加されていることを確認します。

追加されていない場合はプレイドの担当者までご連絡ください。

追加されていない場合はプレイドの担当者までご連絡ください。

ジョブフロー作成時の設定

- function 名:実行したい Function 名

- 行ごとに queue を publish する :ジョブフローの実行結果を Function に送る際、1 行ずつ送信する場合はチェックを入れます。実行結果をまとめて送信する場合はチェックを外します。

Craft Functions に送信されるデータ

data のフォーマットは Function 実行時に送信されるデータ をご確認ください。

kindは"karte/jobflow"が入ります。jsonPayloadのフォーマットは以下の通りです。

jsonPayload: { data: { task_id: "xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx", event_type: 'DATA', value?: 下記参照 } name: "jobflow-name"}| Key | 説明 |

|---|---|

jsonPayload.name | 実行されたジョブフローの名前が入ります。 |

jsonPayload.data.task_id | ジョブフローのジョブを一意に表す ID です。ジョブフロー側で定期実行などを設定していた場合、各実行で変わります。 |

jsonPayload.data.event_type | 固定文字列DATA |

jsonPayload.data.value | ジョブフローで実行されたDatahubクエリの結果が入ります。 |

行ごとにqueueをpublishするオプションについて

設定値によってjsonPayload.data.valueの内容が変わります。

- 行ごとに queue を publish する: 有効 の場合

DATAメッセージはジョブフローのクエリ結果の行数文だけ発行されます。jsonPayload.data.valueはVal1,Val2,Val3のようにカンマ区切りの値が入ります。- 発行された

DATAメッセージは Craft 側で 順不同 に処理されるので注意してください。

- 行ごとに queue を publish する: 無効 の場合

DATAメッセージは 1 度だけ発行されます。 jsonPayload.data.value は header1,header2,header3\nval1,val2,val3\nval4,val5,val6 のように CSV データのヘッダーを含む全ての行が文字列として入ります。

Hook v2 との違い

Hook v2 でトリガーとして利用できる Datahub Jobflow との違いは、「ジョブフローの実行結果を Craft Functions に渡せるかどうか」です。

- Hook v2 トリガーでは、ジョブフローの設定情報のみが Function に送られます。

- Datahub Jobflow Connector では、個々のジョブフローの実行結果(クエリの実行結果)が Function に送られます。